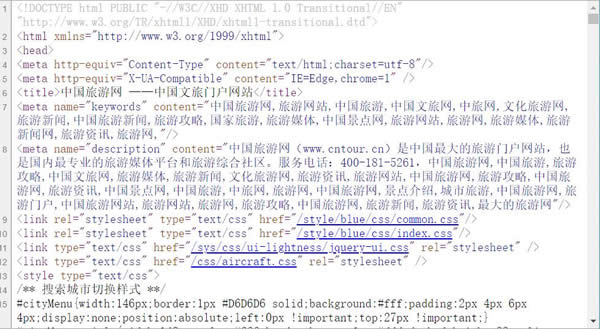

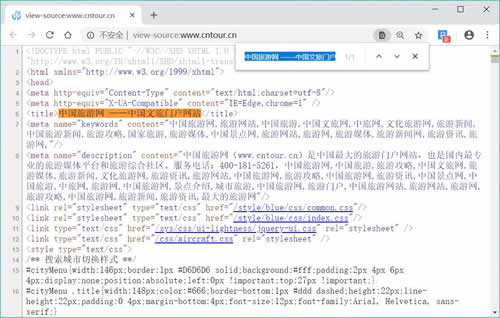

图 1 中国旅游网首页源码

<html>..</html> 表示标记中间的元素是网页

<body>..</body> 表示用户可见的内容

<div>..</div> 表示框架

<p>..</p> 表示段落

<li>..</li>表示列表

<img>..</img>表示图片

<h1>..</h1>表示标题

<a href="">..</a>表示超链接

<html>

<head>

<title> Python 3 爬虫与数据清洗入门与实战</title>

</head>

<body>

<div>

<p>Python 3爬虫与数据清洗入门与实战</p>

</div>

<div>

<ul>

<li><a href="http://task.lmcjl.com">爬虫</a></li>

<li>数据清洗</li>

</ul>

</div>

</body>

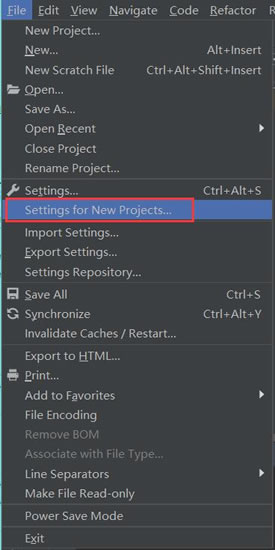

图 2

图 3 淘宝网的robots.txt文件内容

User-Agent:*

Disallow:/

图 4

图 5

图 6

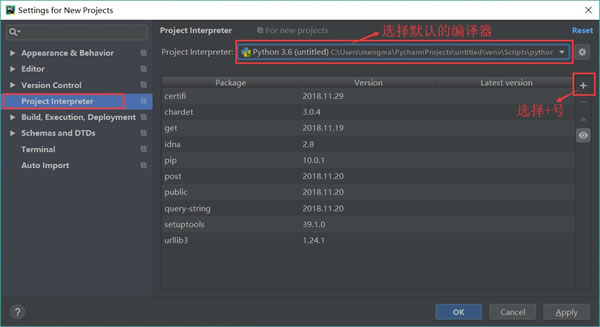

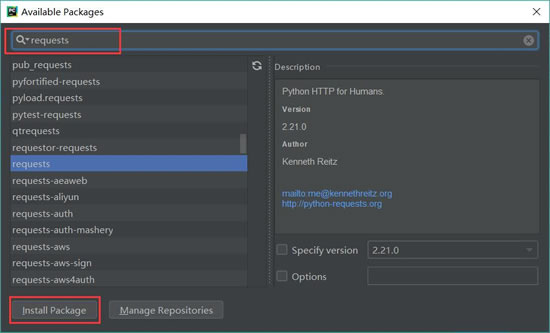

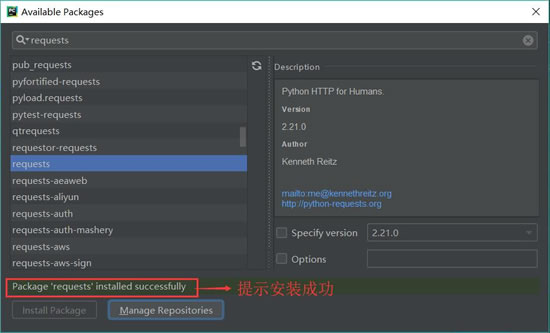

图 7 安装成功

图 8 Response相应

图 9(点此查看高清大图)

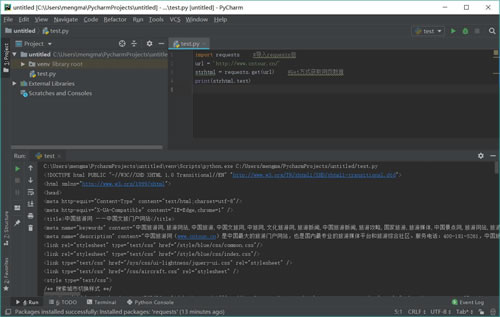

import requests #导入requests包 url = 'http://www.cntour.cn/' strhtml = requests.get(url) #Get方式获取网页数据 print(strhtml.text)运行结果如图 10 所示:

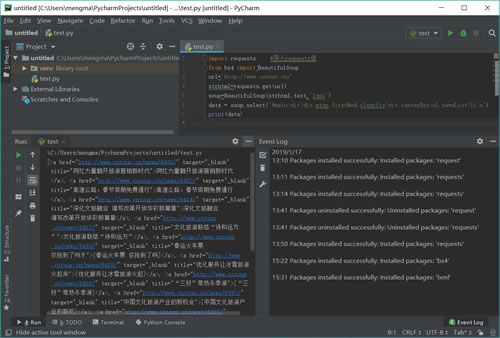

图 10 运行结果效果图(点此查看高清大图)

requests.get

将获取到的数据存到 strhtml 变量中,代码如下:strhtml = request.get(url)

这个时候 strhtml 是一个 URL 对象,它代表整个网页,但此时只需要网页中的源码,下面的语句表示网页源码:strhtml.text

图 11

图 12

图 13

图 14

url = 'http://fanyi.youdao.com/translate_o?smartresult=dict&smartresult=rule'

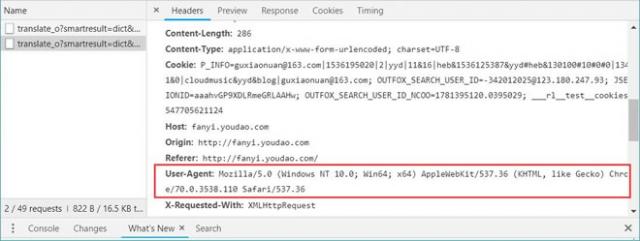

POST 的请求获取数据的方式不同于 GET,POST 请求数据必须构建请求头才可以。

图 15

From_data={'i':'我愛中國','from':'zh-CHS','to':'en','smartresult':'dict','client':'fanyideskweb','salt':'15477056211258','sign':'b3589f32c38bc9e3876a570b8a992604','ts':'1547705621125','bv':'b33a2f3f9d09bde064c9275bcb33d94e','doctype':'json','version':'2.1','keyfrom':'fanyi.web','action':'FY_BY_REALTIME','typoResult':'false'}

接下来使用 requests.post 方法请求表单数据,代码如下:

import requests #导入requests包

response = requests.post(url,data=payload)

import json content = json.loads(response.text) print(content['translateResult'][0][0]['tgt'])使用 requests.post 方法抓取有道翻译结果的完整代码如下:

import requests #导入requests包

import json

def get_translate_date(word=None):

url = 'http://fanyi.youdao.com/translate_o?smartresult=dict&smartresult=rule'

From_data={'i':word,'from':'zh-CHS','to':'en','smartresult':'dict','client':'fanyideskweb','salt':'15477056211258','sign':'b3589f32c38bc9e3876a570b8a992604','ts':'1547705621125','bv':'b33a2f3f9d09bde064c9275bcb33d94e','doctype':'json','version':'2.1','keyfrom':'fanyi.web','action':'FY_BY_REALTIME','typoResult':'false'}

#请求表单数据

response = requests.post(url,data=From_data)

#将Json格式字符串转字典

content = json.loads(response.text)

print(content)

#打印翻译后的数据

#print(content['translateResult'][0][0]['tgt'])

if __name__=='__main__':

get_translate_date('我爱中国')

图 16

import requests #导入requests包

from bs4 import BeautifulSoup

url='http://www.cntour.cn/'

strhtml=requests.get(url)

soup=BeautifulSoup(strhtml.text,'lxml')

data = soup.select('#main>div>div.mtop.firstMod.clearfix>div.centerBox>ul.newsList>li>a')

print(data)

代码运行结果如图 17 所示。

图 17(点此查看高清大图)

from bs4 import BeautifulSoup

首先,HTML 文档将被转换成 Unicode 编码格式,然后 Beautiful Soup 选择最合适的解析器来解析这段文档,此处指定 lxml 解析器进行解析。解析后便将复杂的 HTML 文档转换成树形结构,并且每个节点都是 Python 对象。这里将解析后的文档存储到新建的变量 soup 中,代码如下:soup=BeautifulSoup(strhtml.text,'lxml')

接下来用 select(选择器)定位数据,定位数据时需要使用浏览器的开发者模式,将鼠标光标停留在对应的数据位置并右击,然后在快捷菜单中选择“检查”命令,如图 18 所示:

图 18

图 19 复制路径

#main > div > div.mtop.firstMod.clearfix > div.centerBox > ul.newsList > li:nth-child(1) > a

由于这条路径是选中的第一条的路径,而我们需要获取所有的头条新闻,因此将 li:nth-child(1)中冒号(包含冒号)后面的部分删掉,代码如下:#main > div > div.mtop.firstMod.clearfix > div.centerBox > ul.newsList > li > a

使用 soup.select 引用这个路径,代码如下:data = soup.select('#main > div > div.mtop.firstMod.clearfix > div.centerBox > ul.newsList > li > a')

for item in data:

result={

'title':item.get_text(),

'link':item.get('href')

}

print(result)

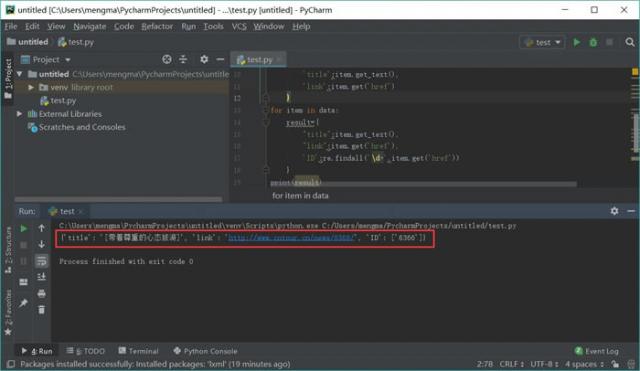

代码运行结果如图 20 所示:

图 20(点此查看高清大图)

\d匹配数字

+匹配前一个字符1次或多次

import re

for item in data:

result={

"title":item.get_text(),

"link":item.get('href'),

'ID':re.findall('\d+',item.get('href'))

}

print(result)

运行结果如图 21 所示:

图 21

图 22

headers={'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.110 Safari/537.36'}

response = request.get(url,headers=headers)

import time

time.sleep(3)

proxies={

"http":"http://10.10.1.10:3128",

"https":"http://10.10.1.10:1080",

}

response = requests.get(url, proxies=proxies)

本文链接:http://task.lmcjl.com/news/16743.html