一. 提出背景

目标检测在图像处理领域有着非常大的占比,过去两年,深度学习在Detection的持续发力,为这个领域带来了变革式的发展:一方面,从 RCNN 到 Fast RCNN,再到

Faster RCNN,不断刷新 mAP;另一方面,SSD、YOLO 则是将性能提高到一个非常高的帧率。

对于视频来讲,相邻帧目标之间存在 明显的上下文关系,这种关系在技术上的表现就是 Tracking,研究过跟踪的童鞋都应该知道 经典算法 TLD,通过 Tracking-Learning-Detection

学习目标的帧间变换,并进行 Location。

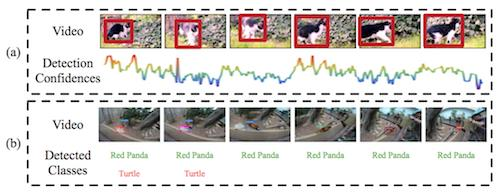

基于视频的目标检测 要解决的是同样的问题,因为 变形、遮挡、运动Blur 等因素导致目标 在 中间帧无法检测到(Appearence 发生很大变化),可以从下图看到,基于 still-image 的方法在某些帧的检测置信度很低。

VID(object-detection-from-video) 在2015年已成为一个 Challenge 方向,主要思路是结合帧间的 Context 信息、Tracking信息,接下来我们要讲的算法 TCNN。

论文名称: T-CNN: Tubelets with Convolutional Neural Networks for Object Detection from Videos

二. T-CNN

论文下载:【arvix】

代码下载:【Github】

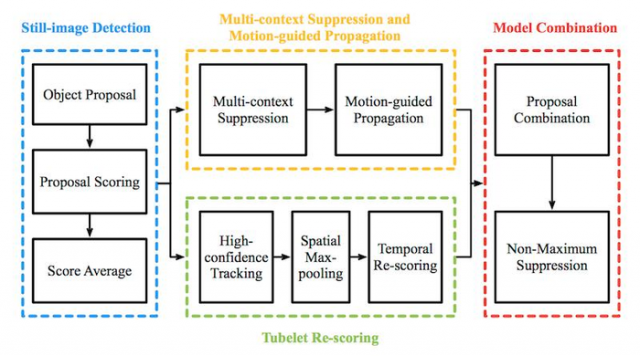

闲话不说,直接给出框架图:

算法分为四个步骤:

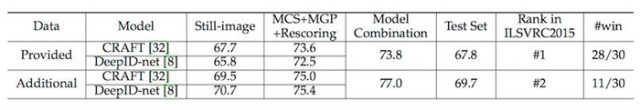

> 论文实现效果

关于这篇论文,读完之后发现水分很大,拼凑的地方比较多,只为了发篇论文,并无亮点,如果我是评委,不会给过的。

饶是如此,VID的第一篇文章,还是把它介绍出来,了解其思想即可不必深究,本人的观点是,在 Real-Time 系统之中基于Detection & Tracking的方法结合就够了,只用到前帧信息(后面帧信息不建议用)。

三. Deep Feature Flow

论文下载:【arvix】

代码下载:【Github】

MSRA 出品,突然感慨这是没有了 孙剑、何凯明的 MSRA,虽然吹的依旧火热,不过与 FAIR、Google Brain差距也是越拉越大。

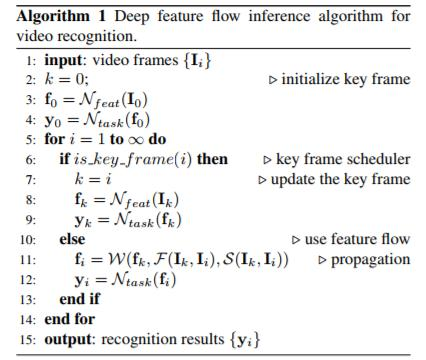

跑题了,这篇文章思路比较简单,受 Detection 效率的制约,在处理实时的视频应用上,结合光流的思路,实现特征图的帧间传播和复用。

算法要点描述为:

> 算法流程

本文链接:http://task.lmcjl.com/news/12213.html