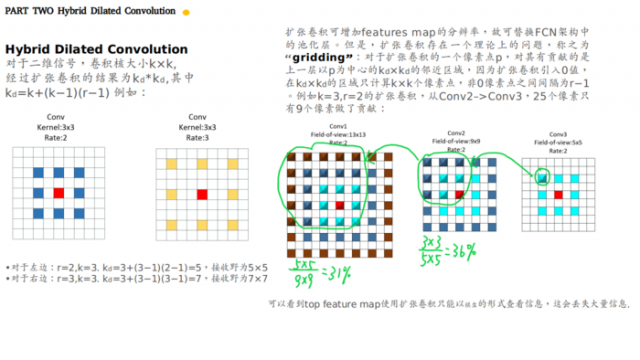

以最佳的101 layer的ResNet-DUC为基础,添加HDC,实验探究了几种变体:

可以看到增加接收野大小会获得较高的精度。如下图所示:

ResNet-DUC-HDC在较大的目标物上表现较好。下图是局部放大:

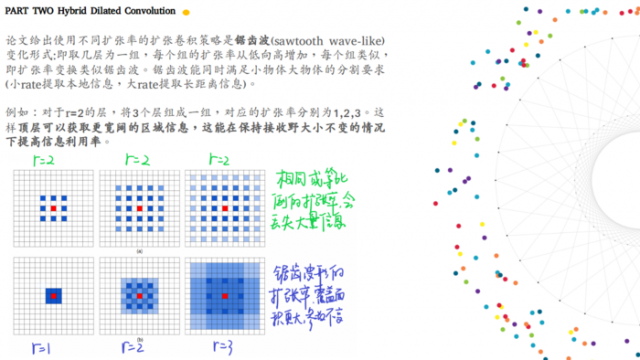

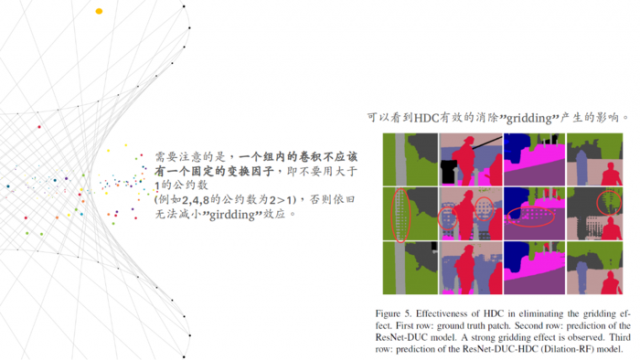

可以看到HDC有效的消除”gridding”产生的影响。

Deeper Networks: 同样尝试了将ResNet-101切换为ResNet-152,使用ResNet152先跑了10个epoch学习了BN层参数,再固定BN层,跑了20个epochs.结果如下:

ResNet152为基础层的有1%的提升。

Test Set Results: 论文将ResNet101开始的3×3的卷积,再不带CRF的情况下达到了80.1%mIoU.与其他先进模型相比如下:

模型同时在coarse labels跑了一圈,与同样以deliated convolution为主的DeepLabv2相比,提升了9.7%.

KITTI有289的训练图片和290个测试图片。示例如下:

因为数据集有限,为了避免过拟合。论文以100的步长在数据集中裁剪320×320的patch. 使用预训练模型,结果如下:

结果达到了state-of-the-art水平.

先用VOC2012训练集和MS-COCO数据集对ResNet-DUC做预训练。再使用VOC2012做fine-tune。使用的图片大小为512×512。达到了state-of-the-art水平:

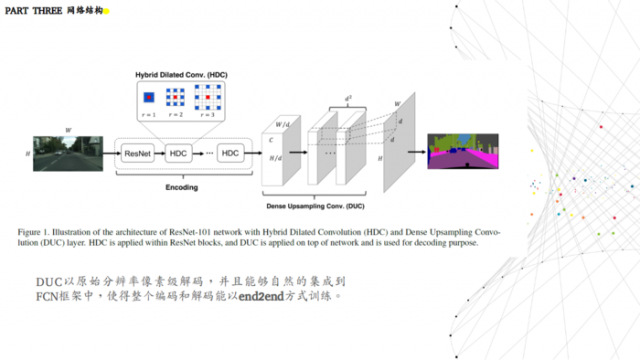

论文提出了简单有效的卷积操作改进语义分割系统。使用DUC恢复上采样丢失的信息,使用HDC在解决”gridding”的影响的同时扩大感受野。实验证明我们的框架对各种语义分割任务的有效性。

本文链接:http://task.lmcjl.com/news/12168.html